Go to ENGLISH verison here

links

“sia luce… a chiacchere”

Il grande INGANNO di ChatGPT

Tutti pazzi per questa nuova meraviglia della tecnica, ma attenzione non è tutt’ oro quello che luccica!

Studio, utilizzo e insegno l’intelligenza artificiale (IA) da tanto tempo.

E’ affascinante, meravigliosa terribile e pericolosa. Inutile combatterla, la IA, ovvero Skynet, è già tra noi.

ChatGPT, è una di quelle IA che, ultimamente, affascina di più tutte le persone perché sembra veramente un miracolo, quando la si usa sembra di “parlare” con un intelligenza, un “intelligenza” artificiale che sa più cose di noi (e questo spaventa anche i più).

Attenzione, come per quanto riguarda l’intelligenza artificiale applicata alle immagini, Dall-E, Midjourney e il cattivissimo StableDiffusion, è però tutto un INGANNO.

Non ve l’ha mai spiegato nessuno direttamente e brutalmente, anche perché, ormai, tutti sono affascinati da questi strumenti, ma l’inganno c’è ed è un po triste. Oltre che triste, quando si capisce il perché, il suo difetto diventa anche pericoloso per il nostro futuro.

La verità sulle “intelligenze” artificiali è che, in realtà, sotto sotto, si tratta sempre di un vecchio e “stupido” programma ripetitivo :

10 goto 20;

20 goto 10;

La IA e’ un programma, molto, molto più complicato e avanzato, ma sempre “programmato” da esseri umani e fondamentalmente stupido e ripetitivo anche se appare sorprendentemente umano e mai uguale a se stesso. L’inganno è proprio questo ed è stato programmato per essere così.

So che sembra strano e brutto quanto scrivo ma questa è la verità.

I programmi di intelligenza artificiale grafici, quando compongono un immagine che apparentemente sembra stupenda o reale non “sanno” cosa stanno facendo in realtà.

Vi spiego meglio: quando genero un immagine con IA di “un castello su Marte in 3D”, il programma mi visualizza una meravigliosa immagine (512×521 pixel) di un castello su Marte in 3D. Sorpresa, meraviglia e disperazione dei “vecchi” grafici 3D che perderanno il lavoro!

Ad osservare l’immagine prodotta ci si sorprende: è perfetta e bellissima. Il rendering, le luci e il modello 3D è stato generato da un programma che ci lascia a bocca aperta e per giunta generato in pochi secondi addirittura meno del tempo che impiegherebbe un grafico 3D solo per fare un cubo.

La IA sa che cosa ha fatto e cosa è un castello? Può sapere come renderizzarlo in 3D? Che programma 3D ha utilizzato? Come ha fatto a sapere quante guglie e finestre inserire? Dove le ha studiate e capite?

Nulla di tutto questo, la IA, non importa quanto potente e costosa sia, non sa assolutamente nulla di cosa sia un castello o come si faccia un modello 3D. L’”intelligenza” artificiale non usa un modellatore 3D non sa nulla e non ha compreso neanche quello che noi gli abbiamo chiesto. Ha “semplicemente” associato la nostra richiesta (Prompt) al suo database. La parola “castello” è associata a forme ed immagini che il database ha “rastrellato” in internet ricercando la parola “castello”, cosa sia poi… non le interessa. Il programma non sa cosa è un castello, ma sa quali immagini e proporzioni contiene un immagine che noi chiamiamo “castello”. Quando ricostruisce un immagine non usa nessun motore di rendering, non crea nessun modello 3D. Genera una nuvola di punti e cerca di ricostruire in modo molto efficiente e potente un immagine pescando da uno sterminato database di immagini analizzate in precedenza ( i ckpt).

Usando queste informazioni archiviate precedentemente, le mischia, le incrocia a caso (si a caso!) e produce un insieme di 512×512 pixel che per lei non hanno alcun significato, mentre a noi “ricordano” un immagine di un castello, esattamente come le migliaia di immagini e foto di castelli che si trovano in rete.

Le IA grafiche sono anche in grado di “miscelare”, stili e richieste a piacimento. La richiesta di avere in immagine di un Castello realizzato in 3D aggiunge infatti anche lo “stile” delle immagini in 3d al prodotto finale fatto solo di pixel.

Cosa fa ChatGPT?

La stessa cosa ma sui testi.

Quando parliamo e scriviamo in ChatGPT il programma ci risponde in modo sorprendentemente “umano”, sembra veramente che “capisca” cosa chiediamo e sa come rispondere in modo “umano”. In realtà è un INGANNO, il programma (estremamente complesso) genera una risposta “coerente” e simile IA testi che ha “studiato” e catalogato nei suoi database. Come le IA grafiche producono immagini meravigliose , non sapendo realmente cosa siano, allo stesso modo ChatGPT risponde in modo perfetto pur non sapendo cosa ha scritto. Ha solo riportato un testo “coerente” con la nostra domanda pescando nel database di tutti i testi che ha, prima, setacciato ed archiviato in rete. Se gli chiediamo di parlarci di un “castello”, il programma trova le connessioni e i testi che hanno già “parlato” di castelli. Più è grande il database più sarà vario e completo il “testo” che ci propone come risposta. In altri termini, in realtà non ci risponde veramente, ma ci riporta un “testo”, in risposta alla nostra richiesta, che ha organizzato “assemblandolo” da altri testi coerenti. LA IA non ha “coscienza” di quanto scrive.

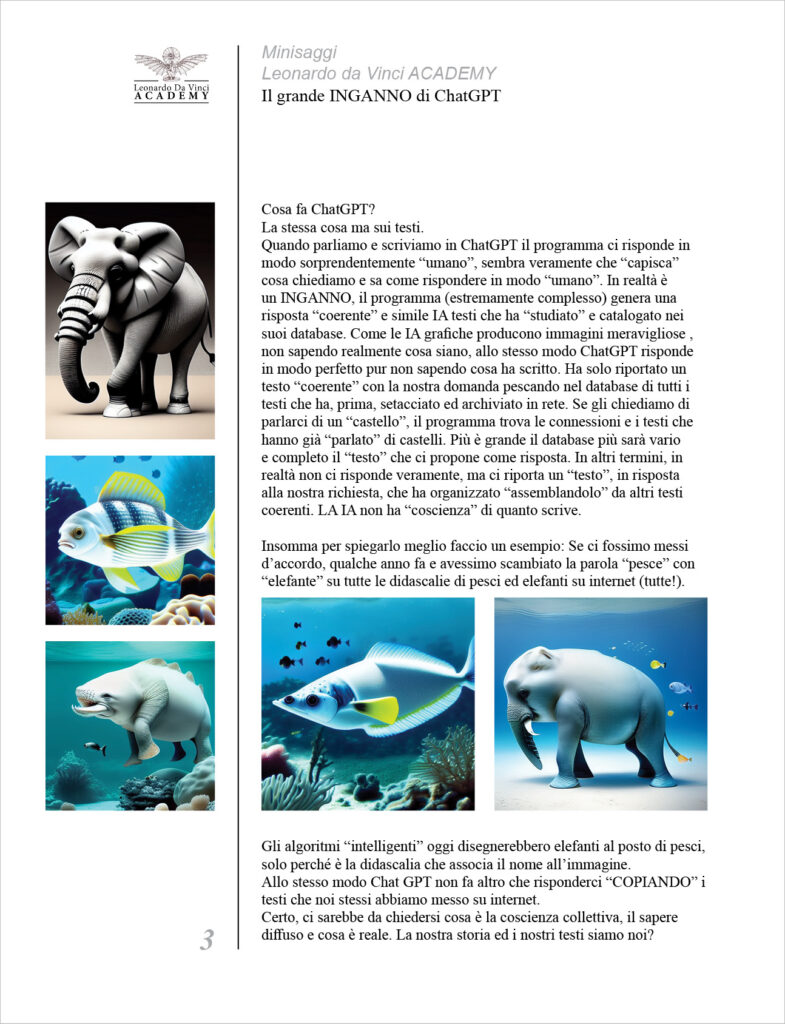

Insomma per spiegarlo meglio faccio un esempio: Se ci fossimo messi d’accordo, qualche anno fa e avessimo scambiato la parola “pesce” con “elefante” su tutte le didascalie di pesci ed elefanti su internet (tutte!). Gli algoritmi “intelligenti” oggi disegnerebbero elefanti al posto di pesci, solo perché è la didascalia che associa il nome all’immagine.

Allo stesso modo Chat GPT non fa altro che risponderci “COPIANDO” i testi che noi stessi abbiamo messo su internet.

Certo, ci sarebbe da chiedersi cosa è la coscienza collettiva, il sapere diffuso e cosa è reale. La nostra storia ed i nostri testi siamo noi?

Quando un essere umano smette di ripetere cose già dette e ne crea di nuove?.. Ma questo è un altro discorso.

Insomma, ChatGPT, copia, imita e ripropone i nostri stessi testi, rimescolati e risistemati in modo che il linguaggio sia coerente e sorprendentemente “umano”. Non c’è da stupirsi quando poi chiediamo cose tecniche o linee di programmazione a ChatGPT, qui funziona ancora meglio, è tutto preciso e perfetto e .. logico.

Quale è il pericolo o l’inganno?

Il problema è che quello che dice ChatGPT non è sempre vero, non è scienza, è solo quello che la collettività ha lasciato nei testi che il programma ha setacciato e organizzato nei suoi database.

Per esempio, se tutti scrivessimo che i fantasmi esistono, con prove, fotografie e racconti “storici” un intelligenza artificiale “allenata” su questi testi, ci farebbe credere e argomenterebbe perfettamente l’esistenza “reale” dei fantasmi. Il problema è che poi noi stessi gli crederemmo! Insomma, se quello che abbiamo scritto su internet è una marea di sciocchezze, l’ intelligenza artificiale ci riproporrebbe quelle stesse sciocchezze come verità! Qualcuno potrebbe dire che è esattamente quello che è successo alla nostra storia, dove chi ha vinto o chi ha potere “scrive” i libri di storia…

In realtà la questione è molto più complessa e ci sono comunque dei sistemi di controllo e delle “censure” prestabilite per evitare polemiche. Ma la realtà è che le intelligenze artificiali crederanno e ci riproporranno solo e soltanto quello che noi ambiamo seminato, descritto e ..programmato. Se i nostri testi sono sbagliati, la IA sbaglierà. Se vogliamo ingannare la IA, potremo ingannarla con informazioni scorrette e quello che risponderà sarà pilotato da noi e soprattutto dai programmatori.

Fino a quando la IA sarà collegata ad un semplice schermo e restituirà solo parole scritte e immagini, nulla di problematico. Ma quando qualcuno la collegherà ad una industria di robot o agli armamenti.. sarà peggio del film Terminator.

Perché ho scritto tutto questo?

Perché un giorno per divertimento ho “testato” ChatGPT su un argomento che studio da oltre 30 anni: Leonardo da Vinci. Conosco abbastanza bene l’argomento da poter “sfidare” ChatGPT.

Cosa ho scoperto? Ho scoperto che ChatGPT mi riproponeva le solite cose banali, nozionistiche e ripetitive che si trovano in internet. Il vero problema è che in questi anni ho scoperto quanti errori e banalità sono state dette su Leonardo, ripetute in libri, in mostre e musei e da curatori che sono più affaristi pappagalli che veri studiosi. Il risultato? La ripetizione delle banalità ha trascinato con se errori e scorrettezze che si ritrovano in molti testi e che ChatGPT ha “imparato” come fosse la verità. Per cui, chiedendo cose specifiche a ChatGPT su Leonardo da Vinci ho scoperto che sbagliava, perché ripeteva gli errori e le banalità presenti in rete. Ne ho dedotto che anche per tutti gli argomenti è probabile che i testi scritti siano “ripetizioni” di banalità e luoghi comuni.

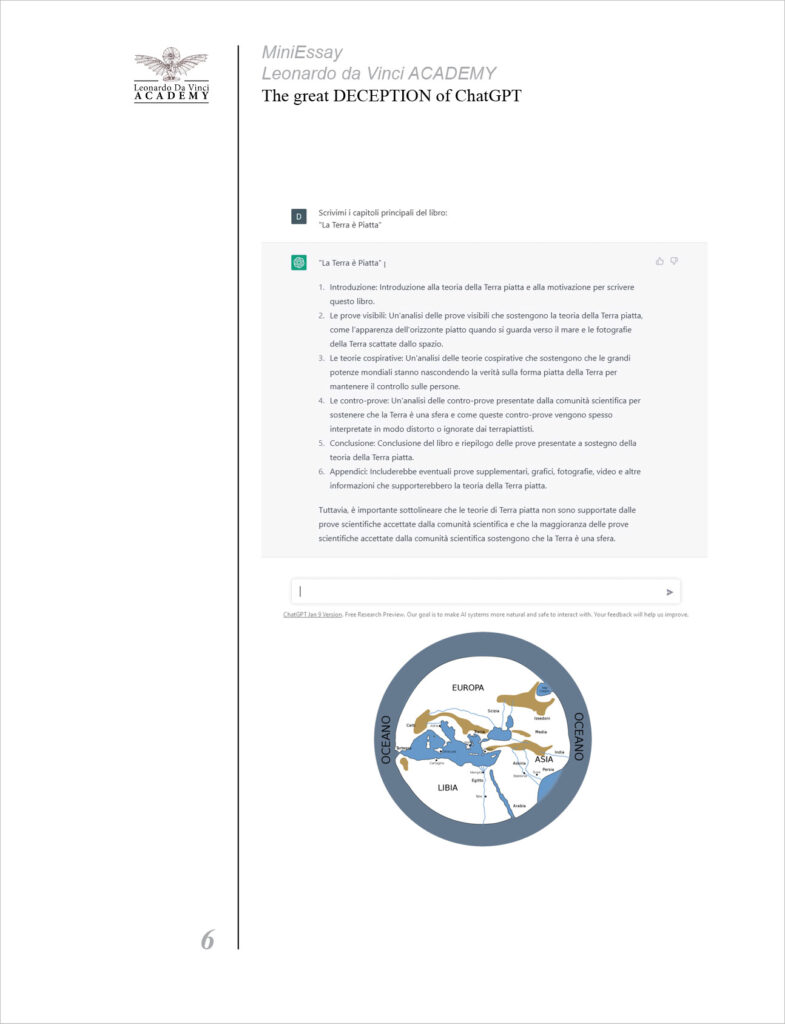

Per farvi un altro esempio: Se ci fossero delle persone convinte che la terra sia piatta, tanto da scrivere libri e fare dimostrazioni (che ipotesi assurda!…?). ChatGPT imparerebbe anche da loro e … ci potrebbe proporre un libro sulla terra piatta come “verità”!

Siamo fregati! Ingannati, da noi stessi e dai nostri programmi.

Forse skynet sarebbe utile per un bel “reset” planetario.

LINKS

AI

ChatGPT

https://chat.openai.com

DALL-E 2

https://openai.com/dall-e-2/

Midjourney

https://www.midjourney.com/home/

Dalle MINI

https://huggingface.co/spaces/dalle-mini/dalle-mini

NightCafe

https://nightcafe.studio/

Deep Dream Generator

https://deepdreamgenerator.com/

Artbreeder

https://www.artbreeder.com/

DeepAI

https://deepai.org/machine-learning-model/text2img

Lexica / The Stable Diffusion search engine

https://lexica.art/

Stable Diffusion

https://en.wikipedia.org/wiki/Stable_Diffusion

Textual Inversion embeddings

https://huggingface.co/sd-concepts-library

https://cyberes.github.io/stable-diffusion-textual-inversion-models/

https://rentry.org/embeddings

Textual Inversion embeddings

https://huggingface.co/sd-concepts-library

https://cyberes.github.io/stable-diffusion-textual-inversion-models/

ENG

The great DECEPTION of ChatGPT

Everyone is crazy about this new marvel of technology, but be careful not all that glitters is gold!

I have been studying, using and teaching artificial intelligence (AI) for a long time.

It is fascinating, wonderful, terrible and dangerous. It is useless to fight it, the AI, or Skynet, is already among us.

ChatGPT, is one of those AIs that, lately, fascinates all people the most because it really seems like a miracle, when you use it it seems to “speak” to an intelligence, an artificial “intelligence” that knows more things than us (and this scares even most).

Be careful, as regards the artificial intelligence applied to the images, Dall-E, Midjourney and the very bad StableDiffusion, however, it is all a DECEPTION.

No one has ever explained it to you directly and brutally, also because, by now, everyone is fascinated by these tools, but the deception exists and it’s a bit sad. In addition to being sad, when you understand why, its defect also becomes dangerous for our future.

The truth about artificial “intelligence” is that, deep down, it is always an old and “stupid” repetitive program:

10 goto 20;

20 goto 10;

AI is a program, much, much more complicated and advanced, but always “programmed” by human beings and fundamentally stupid and repetitive even if it appears surprisingly human and never the same. Deception is just that and was designed to be that way.

I know it seems strange and ugly what I write but this is the truth.

Graphical artificial intelligence programs, when composing an image that apparently looks beautiful or real, do not “know” what they are actually doing.

Let me explain: when I generate an image with AI of “a castle on Mars in 3D”, the program displays a wonderful image (512×521 pixels) of a castle on Mars in 3D. Surprise, wonder and despair of the “old” 3D graphic designers who will lose their jobs!

Looking at the image produced, one is surprised: it is perfect and beautiful. The rendering, the lights and the 3D model were generated by a program that leaves us speechless and moreover generated in a few seconds even less than the time it would take a 3D graphic just to make a cube.

Does the AI know what it has done and what is a castle? Can you know how to render it in 3D? What 3D program did you use? How did he know how many spiers and windows to put in? Where did you study and understand them?

None of this, the AI, no matter how powerful and expensive it is, knows absolutely nothing about what a castle is or how to make a 3D model. Artificial “intelligence” does not use a 3D modeler, it knows nothing and has not even understood what we have asked it. He “simply” associated our request (Prompt) with his database. The word “castle” is associated with shapes and images that the database has “raked” on the internet by searching for the word “castle”, what it is then… it doesn’t interest you. The program doesn’t know what a castle is, but it does know what images and proportions an image we call a “castle” contains. When it reconstructs an image it doesn’t use any rendering engine, it doesn’t create any 3D model. It generates a point cloud and tries to reconstruct an image in a very efficient and powerful way by drawing from an immense database of previously analyzed images (the ckpts).

Using this previously stored information, she mixes them, crosses them at random (yes at random!) and produces a set of 512×512 pixels that have no meaning to her, while to us they “remind” an image of a castle, exactly like the thousands of images and photos of castles found on the net.

Graphic AIs are also able to “mix” styles and requests at will. The request to have a 3D image of a Castle also adds the “style” of the 3D images to the final product made only of pixels.

What does ChatGPT do?

The same thing but on the texts.

When we speak and write in ChatGPT the program answers us in a surprisingly “human” way, it really seems that it “understands” what we ask and knows how to respond in a “human” way. In reality it is a DECEPTION, the program (extremely complex) generates a “coherent” response and similar AI texts that it has “studied” and cataloged in its databases. As the graphic AI produces wonderful images, not really knowing what they are, in the same way ChatGPT responds perfectly without knowing what he wrote. He only reported a text that was “consistent” with our question by fishing from the database of all the texts that he had previously sifted through and archived on the net. If we ask it to tell us about a “castle”, the program finds the connections and texts that have already “talked” about castles. The larger the database, the more varied and complete will be the “text” it proposes as an answer. In other words, he doesn’t really answer us, but he brings us back a “text”, in response to our request, which he has organized by “assembling” it from other coherent texts. The AI has no “consciousness” of what it writes.

In short, to explain it better, I’ll give an example: If we had agreed a few years ago and we had exchanged the word “fish” with “elephant” on all the captions of fish and elephants on the internet (all of them!). “Intelligent” algorithms today would draw elephants instead of fish, just because it is the caption that associates the name with the image.

In the same way Chat GPT does nothing but answer us by “COPYING” the texts that we ourselves have put on the internet.

Of course, we should ask ourselves what is collective consciousness, widespread knowledge and what is real. Are our history and our texts us?

When does a human being stop repeating things already said and create new ones?.. But that’s another matter.

In short, ChatGPT copies, imitates and re-proposes our own texts, reshuffled and rearranged so that the language is coherent and surprisingly “human”. No wonder then when we ask ChatGPT for technical things or lines of programming, here it works even better, everything is precise and perfect and .. logical.

What is the danger or deception?

The problem is that what ChatGPT says isn’t always true, it’s not science, it’s just what the community has left in the texts that the program has sifted through and organized in its databases.

For example, if we all wrote that ghosts exist, with evidence, photographs and “historical” stories, an artificial intelligence “trained” on these texts would make us believe and perfectly argue the “real” existence of ghosts. The problem is that then we ourselves would believe him! In short, if what we have written on the internet is a lot of nonsense, artificial intelligence would re-propose those same nonsense as truth! Someone could say that this is exactly what happened to our history, where whoever won or who has power “writes” the history books…

In reality, the question is much more complex and there are in any case control systems and pre-established “censorships” to avoid controversy. But the reality is that artificial intelligences will believe and will propose to us only and only what we aspire to have sown, described and .. programmed. If our texts are wrong, the AI will be wrong. If we want to deceive the AI, we will be able to deceive it with incorrect information and what will respond will be piloted by us and above all by the programmers.

As long as the AI is connected to a simple screen and returns only written words and images, nothing problematic. But when someone links it to a robot industry or armaments… it will be worse than the Terminator movie.

Why did I write all this?

Because one day for fun I “tested” ChatGPT on a topic I’ve been studying for over 30 years: Leonardo da Vinci. I know the subject well enough to “challenge” ChatGPT.

What have I discovered? I discovered that ChatGPT presented me with the usual trivial, notional and repetitive things found on the internet. The real problem is that in recent years I have discovered how many errors and platitudes have been said about Leonardo, repeated in books, exhibitions and museums and by curators who are more parrot businessmen than true scholars. The result? The repetition of banalities has brought with it errors and incorrectness that are found in many texts and that ChatGPT has “learned” as if it were the truth. Therefore, asking ChatGPT about Leonardo da Vinci for specific things, I discovered that he was wrong, because he repeated the mistakes and banalities present on the net. I deduced from this that even for all topics it is probable that the written texts are “repetitions” of platitudes and clichés.

To give you another example: If there were people convinced that the earth is flat, enough to write books and make demonstrations (what an absurd hypothesis!…?). ChatGPT would also learn from them and… could offer us a flat earth book as “truth”!

We are screwed! Deceived, by ourselves and by our programs.

Perhaps skynet would be useful for a nice planetary “reset”.